Von Überwachung im Supermarkt über Grenzkontrollen bis zu Alexa und Spotify: Der Markt für Emotionserkennungstechnologien boomt. Dabei ist ihre wissenschaftliche Grundlage höchst umstritten – und die Systeme verschärfen soziale Ungerechtigkeit.

Als die Pizzen geliefert werden, schlägt der Detektor im Klassenraum Alarm. Was ist passiert? Etwa ein Anschlag?

Es ist das Jahr 2019, beinahe jede Woche hört man in den Nachrichten von einem Schul-Amoklauf. Über hundert Schulen in den Vereinigten Staaten nutzen daher Überwachungsgeräte. Die sogenannten „Aggression Detectors“ hören Stimmen und andere Geräusche aus der Umgebung ab und analysieren sie mittels Algorithmen auf verdächtige Töne. Analysiert wird dabei die Tonalität der aufgenommenen Personen. Klingt jemand aggressiv oder aufgeregt, also nach möglicher Gefahr, geben sie eine Warnung ab.

Dieses Mal ist es ein Fehlalarm. Die begeisterten Rufe der Schüler*innen über eine Pizza-Lieferung haben den Detektor ausgelöst. Die Pizzen bestellt hat ein Team der investigativen Nachrichtenredaktion ProPublica. Zusammen mit den Schüler*innen untersuchen sie an diesem Tag, wie gut die Detektoren wirklich funktionieren.

Die Ergebnisse sind erschreckend, aber nicht überraschend. Ein raues Husten löst den Alarm aus, ein Video eines Comedians, der Happy-Birthday-Chor einer Gruppe Schüler*innen. Selbst einer der Hersteller von Aggressionsdetektoren räumt vor ProPublica ein, dass die Software nicht fehlerfrei ist und vor allem harschere Töne als aggressiv einstuft. Expert*innen bezweifeln deshalb die Nützlichkeit der Geräte, da Amokläufer vor Anschlägen eher ruhig als verbal aggressiv auftreten.

Trotzdem werden diese Systeme in Schulen, Krankenhäusern, Banken, Geschäften und Gefängnissen eingesetzt. Und Aggressionsdetektoren stellen nur einen Bruchteil der inzwischen weltweit eingesetzten Emotion-Recognition-Technologien.

Was ist Emotionserkennung?

Emotionserkennung ist ein Prozess, der audiovisuelle Signale und biometrische Daten analysiert, um Annahmen über den Emotionszustand der analysierten Person zu treffen. Über Kameras und Mikrofone werden beispielsweise Gesichtsausdrücke, die Stimme, die Iris oder der Gang analysiert. Bei Methoden, die eine direkte Messung am Körper voraussetzen, wird durch die Analyse von Körpertemperatur, Hautspannung, Herzfrequenz oder Gehirnströmen eine Aussage über den emotionalen Zustand getroffen.

Auch Klick- und Posting-Verhalten wird genutzt, um Emotionen vorherzusagen. So bot Facebook beispielsweise die Möglichkeit, Werbeanzeigen gezielt für traurige, unsichere, gestresste oder sich wertlos fühlende Teenager zu schalten.

Affective Computing nennt sich die Disziplin, aus denen diese Emotionserkennungstechnologien hervorgehen. Geprägt hat diese Disziplin Rosalind Picard, Professorin am MIT, und Mitgründerin von Affectiva. Sie beschreibt Affective Computing als die interdisziplinäre Erforschung und Entwicklung von Systemen, die menschliche Emotionen erkennen und verarbeiten sollen.

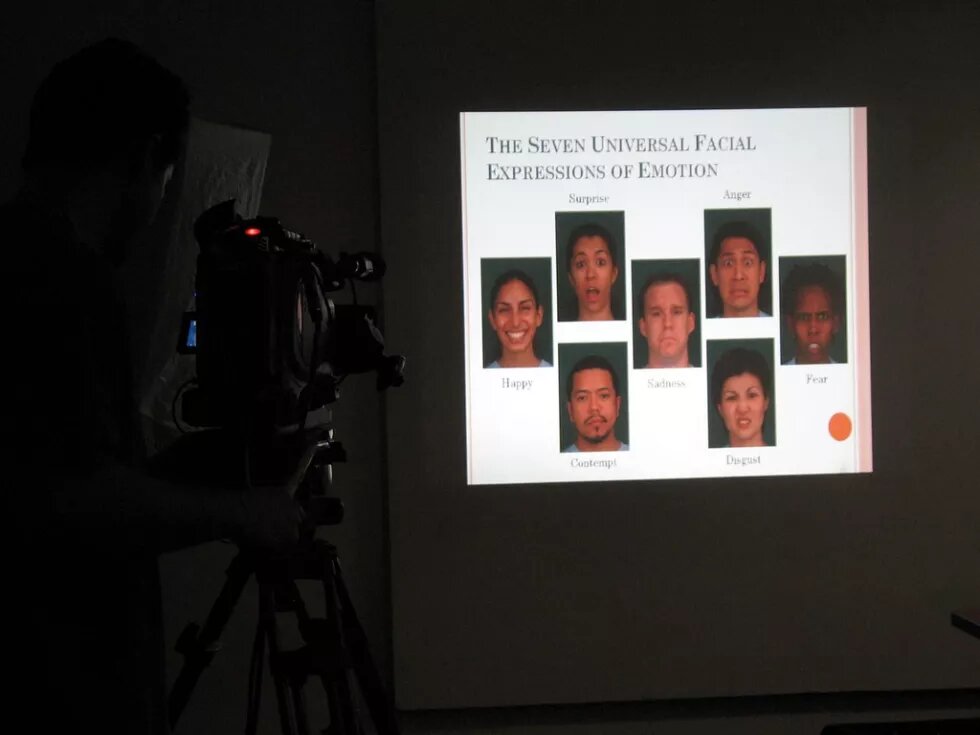

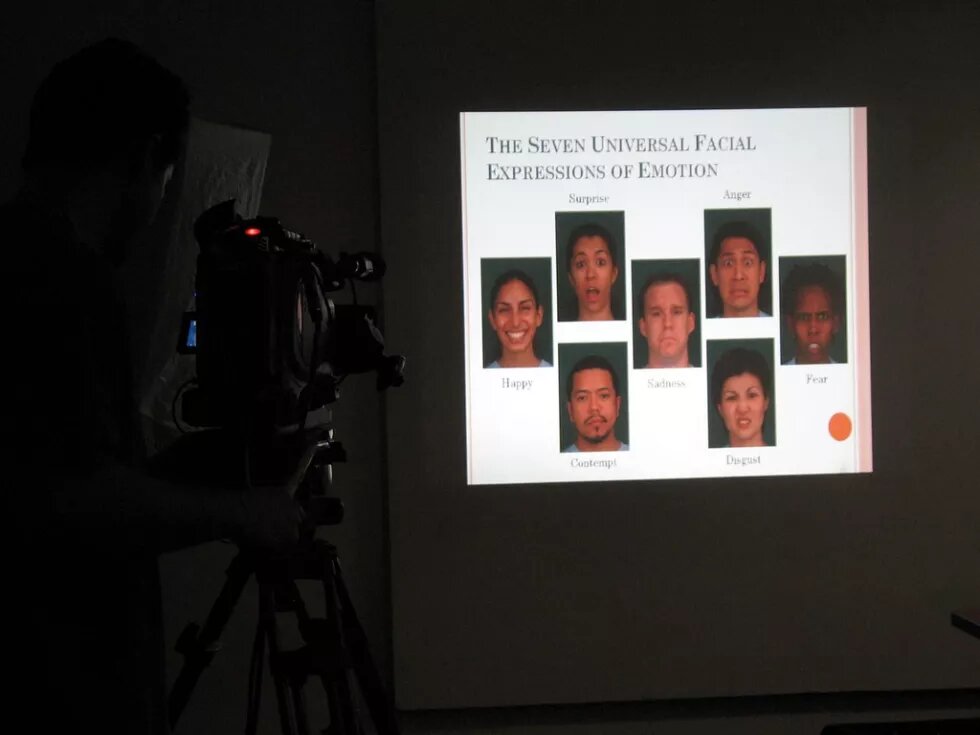

Emotionserkennung im Gesicht basiert unter anderem auf der Arbeit des US-Psychologen Paul Ekman. Auf Grundlage existierender Forschung untersuchte er sechs Basisemotionen: Freude, Wut, Ekel, Furcht, Traurigkeit und Überraschung. Diese Emotionen seien, so Ekman, bei allen Menschen vorhanden – ganz unabhängig von ihrer Kultur oder Sozialisation. Das Konzept dieser vermeintlich universellen Emotionen ist wissenschaftlich umstritten, dennoch bilden sie die Grundlage für die Klassifikation emotionaler Gesichtsausdrücke, auf die sich die Anbieter von Emotionserkennungssystemen berufen.

Picard führt in ihrem Paper von 1995 aus, dass sich durch Affective Computing zwar physische Veränderungen in Gesichtsausdrücken, Stimmen und in anderen Biodaten messen lassen, und diese auch mit Emotionen korrelieren. Aber auf dieser Grundlage ließen sich „noch keine Gedanken lesen“.

Auch 2021 sind sich Emotionsforscher*innen noch nicht einig, wie Emotionen entstehen und wie sie sich im Körper manifestieren. Sie sind sich nicht einmal darüber einig, welche und wie viele Emotionen es überhaupt gibt. In der Wissenschaft herrscht große Uneinigkeit darüber, ob Emotionserkennungssysteme wirklich korrekt menschliche Emotionen erkennen können.

Nach der Analyse von über tausend Studien zu Emotionsausdrücken kommen Autor*innen einer Studie von 2019 zum Schluss, dass es dafür keine zuverlässigen Beweise gibt. Sie schreiben: „Die verfügbaren wissenschaftlichen Beweise deuten darauf hin, dass Menschen manchmal lächeln, wenn sie glücklich sind, die Stirn runzeln, wenn sie traurig sind, einen finsteren Blick aufsetzen, wenn sie wütend sind", jedoch variiere „die Art und Weise, wie Menschen Wut, Ekel, Angst, Glück, Traurigkeit und Überraschung kommunizieren, [...] erheblich zwischen verschiedenen Kulturen, Situationen und sogar zwischen verschiedenen Personen innerhalb einer einzigen Situation. Darüber hinaus drücken ähnliche Konfigurationen von Gesichtsbewegungen variabel Instanzen von mehr als einer Emotionskategorie aus. Tatsächlich kommuniziert eine bestimmte Konfiguration von Gesichtsbewegungen, wie z.B. ein finsterer Blick, oft etwas anderes als einen emotionalen Zustand.“

Die Menschenrechtsorganisation Article 19 hat drei Annahmen formuliert, mit denen Anbieter*innen von Emotionserkennungstechnologien Verkauf und Nutzen der Technik rechtfertigen – obwohl es dafür keine ausreichende wissenschaftliche Grundlage gibt:

- Der Ausdruck von Emotion ist universal bei allen Menschen gleich.

- Aus diesen Ausdrücken können die wahren Gefühle der Analysierten abgeleitet werden.

- Diese Schlussfolgerungen über Gefühle sind zuverlässig genug, um darauf basierend Entscheidungen zu treffen.

Wenn also Firmen behaupten, dass sie objektiv analysieren können, wie sich ein Mensch fühlt, dann ist das ein Verkaufsversprechen, das nicht eingehalten werden kann. Trotzdem boomt der Markt.

Vom Vorstellungsgespräch bis Spotify: Alle wollen Gefühle lesen

Viele Firmen in unterschiedlichen Branchen und auch Behörden sind an dem Erkennen von Emotionen interessiert. Das US-amerikanische Videorecruiting-Tool Hirevue Assessments beispielsweise analysiert Bewerber*innen auf ihre Wortwahl, Tonalität, ihre angebliche Begeisterung, und bis 2021 auch ihre Mikroexpressionen, um sie dann automatisiert („backed by science“) für Konzerne wie Hilton, Unilever oder Urban Outfitters zu ranken. Mittlerweile bieten Universitäten Kurse für ihre Studierenden an, um sich auf die Videointerviews ohne menschliches Gegenüber bestmöglich vorzubereiten. Die chinesische Firma Taigusys verkauft ihre Emotionserkennungssysteme an Schulen zur Überwachung von Schüler*innen und Lehrpersonen, an Pflegeheime, Einkaufszentren, Parkhäuser, Gefängnisse und Polizeistationen. Auch Amazon arbeitet daran, die KI-Assistenz Alexa mit Emotion Recognition auszustatten, um den Gefühlszustand der Nutzer*innen aus der Stimme lesen zu können. Der Musik-Streamingdienst Spotify hat ein Patent eingereicht, um den emotionalen Zustand, das Geschlecht, das Alter oder den Akzent von Menschen in der Umgebung des Sensors oder Geräts zu analysieren, um passendere Musik zu empfehlen. Am 2. April wurde dem Patent stattgegeben.

Auch an den EU-Außengrenzen wird Emotionserkennnung eingesetzt. In Ungarn, Griechenland und Lettland fand bis 2019 ein drei Jahre dauernder Testversuch statt: die Erprobung des umfassenden Systems iBorderCtrl, das die Grenzkontrollen effizienter und somit billiger machen sollte. Auch sollte iBorderCtrl den Grenzbeamten helfen, illegalisiert einwandernde Personen zu erkennen, um dadurch, so die Website der EU-Kommission, „zur Prävention von Kriminalität und Terrorismus beizutragen.“ Einreisende wurden innerhalb der Pilotstudie einem sogenannten digitalen Lügendetektortest unterzogen, um Menschen zu erkennen, die versuchen, die Grenzbeamten absichtlich zu täuschen. Dafür wurden sie gefilmt und aufgezeichnet, anschließend mit Polizei-Datenbanken und Social Media abgeglichen und einer automatisierten Risikoeinschätzung unterzogen. Im Falle eines Verdachts konnte es zu Fingerabdruck- und Handvenenaufzeichnungen kommen. Auf der Website der EU-Kommission ist das Pilotprojekt unter „Success Stories“ gelistet, die EU hat dafür 4,5 Millionen Euro bezahlt.

Die Technik hinter Emotionserkennung

Aber wie funktionieren diese Technologien eigentlich? Emotion Recognition gehört zum Bereich der Machine-Learning-Systeme. Letztere werden meistens als KI bezeichnet. Machine Learning bedeutet, dass ein Computersystem keine genaue Anleitung mehr braucht, um ein Problem zu lösen, sondern den Lösungsweg anhand einer großen Menge an Beispieldaten berechnen kann. Damit ein Machine-Learning-System Emotionen in Fotos mit menschlichen Gesichtern analysieren kann, braucht es also eine große Menge an Beispielfotos von Menschen. Die Gesichter in den Beispielfotos werden mit Labeln versehen. In einigen Fällen schauen sich Menschen („human annotators“) die Fotos an, und schreiben dazu, welche Emotion sie darauf wahrnehmen. In anderen Fällen geben Firmen bei Plattformen wie Amazons Mechanical Turk in Auftrag, dass Clickworker*innen für Centbeträge Fotos von sich machen, auf denen sie bestimmte Emotionen spielen. So wird festgelegt, wie zum Beispiel ein staunendes Gesicht aussehen soll. Das Machine-Learning-System wird alle kommenden Gesichter an den Gesichtern messen, die via der Datenbank vermessen wurden.

In den vergangenen Jahren haben Studien immer wieder gezeigt, dass die für Machine Learning genutzten Datasets nicht divers genug waren, und dadurch für dominante Gruppen besser funktionieren als für marginalisierte. Deutlich wurde auch, dass sich in den Datasets gesellschaftliche Normen widerspiegeln.

Was ist normal?

Aber wer bestimmt diese Normen? Ob im Geschäft, im Jobinterview oder in der Schule – was ist eigentlich eine „normale“ Art des Schauens, Gehens und Verhaltens? Alle diese Emotionserkennungssysteme beruhen auf großen Datensätzen, in denen das Verhalten einer Mehrheit oder ein vorher festgesetztes, gewünschtes Verhalten als richtig erachtet wird.

Vaakeye, eine japanische AI-Software zur Diebstahlüberwachung in Geschäften, wurde angeblich anhand von 100.000 Stunden Surveillance-Videodaten trainiert, um „Unruhe, Nervosität oder andere verdächtige Gesten“ zu erkennen. Doch nicht alle Menschen reagieren gleich. Für Menschen, die Panikattacken erleben, können Geschäfte wie Supermärkte besonders anstrengend sein und Nervosität und Unruhe auslösen. Auch Menschen, die stark sehbehindert sind, verhalten sich möglicherweise anders als die sehende Dominanzgesellschaft bei einem Supermarktbesuch. Wen markiert das System hier als verdächtig?

Auch beim Recruiting-Tool von Hirevue Assessments werden Tonalität und das Gesagte, und bis Anfang 2021 auch die Körpersprache und Mikroexpressionen gegen eine Norm abgeglichen – die Norm der bereits bestehenden Mitarbeiterinnen eines Unternehmens, die als Blaupause für ideale Kandidatinnen dienen. Ähnlich ist es bei der deutschen Firma Precire, die dafür Sprachsamples nutzt. Diese Systeme bestrafen so möglicherweise Menschen, die nicht wie die bereits angestellten Personen sprechen, oder Menschen, die nicht in ihrer Erstsprache interviewt werden, die nervös sind oder irgendwie anders nicht ins Modell passen.

Im Bildungsbereich wird Emotionserkennung angewandt, um aufzuzeigen, wann Schüler*innen unaufmerksam oder unkonzentriert sind. So sollen ihre Leistungen verbessert werden. In einem viralen Video tragen chinesische Schüler*innen Stirnreifen des US-Anbieters BrainCo, mit deren Hilfe ihre Aufmerksamkeit kontinuierlich überprüft werden sollte. Diese Werte wurden dann in Chatgruppen mit den Eltern geteilt.

Für Erwachsene gibt es ähnliche Tools: Die US-amerikanische Firma Emotiv hat Sensoren entwickelt, die an In-Ear-Kopfhörer erinnern und die Gehirnströme auf Anzeichen von Stress, Fokus und Aufmerksamkeit überwachen sollen. Neurolog*innen hinterfragen, wie gut solche Systeme zur Hirnstrommessung funktionieren können, wenn sie selbst unter Labor-Bedingungen spezifische Anpassungen, viele Elektroden und geschulte Hände benötigen. Aber vielleicht ist das auch gar nicht so wichtig, wenn Manager und Geschäftsetage nur fest daran glauben, dass sich damit Einsparungen vornehmen lassen.

Der Rüstungskonzern Thales schreibt auf seiner Website über KI-Emotionserkennung, man könne die psychische Gesundheit z.B. von Soldat*innen unterstützen, indem man ihre Stimme und Background-Smartphone-Daten analysiert. Auch könne KI „beispielsweise die Gesichter von Mitarbeitenden in einem Lager überwachen und bei Anzeichen von Müdigkeit vorschlagen, dass die Person eine Pause einlegt, bevor sie einen Fehler macht."

Wer misst? Und wer wird gemessen?

KI zur Unterstützung von Mental Health und Arbeiter*innenrechten? Betrachtet man, wie ähnliche Systeme heute schon eingesetzt werden, ergibt sich ein anderes Bild. In den Amazon Warehouses tragen die Mitarbeitenden bereits Armbänder, die ihre Handbewegungen und ihren Standort tracken. „Wenn Mitarbeitende zu lange Pausen beim Scannen von Paketen einlegen, generiert das System automatisch Warnungen und schließlich kann der*die Mitarbeiter*in entlassen werden. Einige Mitarbeitende in den Warenhäusern haben angegeben, dass sie Toilettenpausen vermeiden, um ihre Zeit im Einklang mit den Erwartungen zu halten.“

Was wären mögliche Folgen und Überlegungen von Unternehmensseite beim Einsatz von Emotionserkennung? Ein Mitarbeiter ist am Abend viel produktiver? Am besten, er übernimmt nur noch die Abendschichten. Eine Mitarbeiterin ist im zweiten Monat in Folge laut System zu unkonzentriert? Vielleicht ist es Zeit, sie gehen zu lassen.

Ganz grundsätzlich stellt sich bei Technologien dieser Art die große Frage: Wer muss sich messen lassen? In den Design- und Engineering-Abteilungen von Amazon lässt man sich höchstens freiwillig einen Mikrochip implantieren, um die Arbeitsräume ohne Zugangskarte betreten zu können. Personen aber, die ohnehin prekär beschäftigt sind, bleibt oft keine Wahl.

An Emotionserkennungssystemen kann man gut die Verschränkungen von Herrschaftssystemen betrachten. Oftmals sind die von Klassismus betroffenen, häufig extrem prekär beschäftigten Arbeitenden aus den Versandzentren und Fabriken auch gleichzeitig Immigrant*innen oder migrantisierte Menschen. Und Rassismus spiegelt sich auch direkt in Emotion-Recognition-Technologien, wie Lauren Rhue in ihrer Studie zeigt: Sie beweist, dass zwei bekannte Systeme zur Emotionsanalyse den Gesichtern Schwarzer Männer mehr negative Emotionen zuordnen als den Gesichtern weißer Männer. Rhue testete 400 NBA-Spielerfotos, die ausgewählt wurden, weil sie sich in Kleidung, Sportlichkeit, Alter und gelesenem Geschlecht ähneln. Sie schreibt: „Beide [Systeme] wiesen Schwarzen Spielern im Durchschnitt mehr negative emotionale Bewertungen zu, egal wie sehr sie lächelten." Rhues Untersuchung zeigte, dass die Gesichter der Schwarzen Spieler bei jedem Lächeln durchweg als wütender bewertet wurden als die der weißen.

Der Markt wächst – obwohl Menschenrechte gefährdet sind

Es gibt also Softwares, die etwas versprechen, bei dem sich Forscher*innen selbst noch nicht einig sind, ob und wie es überhaupt möglich ist: Emotionen messen, automatisiert und außerhalb der kontrollierten Umgebung eines Labors. Für viele Menschen könnten diese Programme nicht schädlich sein. Für andere wiederum schon. Und diese Menschen sind seltener in einer Position der Macht, um frei entscheiden zu können, ob sie ihre Gesichter und Stimmen analysiert haben wollen.

Die Wissenschaftlerin und Direktorin des AI Now Institute, Kate Crawford, nennt diesen Wunsch, „aus den äußeren Erscheinungen einer Person falsche Annahmen über innere Zustände und Fähigkeiten zu ziehen, mit dem Ziel, mehr über die Person herauszufinden, als sie preisgeben will“, den phrenologischen Impuls. Die Pseudowissenschaft Phrenologie, in der Schädel vermessen und zur Vorhersage geistiger Eigenschaften herangezogen werden, wurde von weißen Europäer*innen u.a. dafür genutzt, die Welt in unterschiedliche und unterschiedlich wertige Rassen zu unterteilen, um damit Verbrechen wie Kolonisierung und Versklavung von Schwarzen Menschen oder die Verfolgung von Juden und den Holocaust zu rechtfertigen.

Emotion-Recognition-Systeme reproduzieren nachweislich Rassismen und bilden Normen und „Normalverhalten“ in der Gesellschaft nach. Trotzdem werden sie eingesetzt, denn sie versprechen ein schnelleres Recruiting, mehr Sicherheit oder einen besseren Zugang zu den Bedürfnissen von möglichen Kund*innen. Vor allem aber versprechen sie mehr Effizienz und finanziellen Gewinn. Dies gilt auch für die Produzent*innen solcher Technologien. Laut Schätzungen wird der Emotion-Recognition-Markt bis 2024 auf einen Wert von 90 Milliarden US-Dollar ansteigen. Ein einziger Aggressionsdetektor allein kostet bereits um die 1000 Dollar. Geld, das für Counseling und die Löhne von Sozialarbeiter*innen ausgegeben werden könnte.

Im Februar veröffentlichte die Menschenrechtsorganisation Article 19 einen Bericht, in dem sie Design, Entwicklung, Verkauf und Einsatz von Technologien zur Emotionserkennung mit internationalen Menschenrechtsstandards unvereinbar erklärte. Dutzende zivilgesellschaftliche Organisationen wie EDRi oder Algorithmwatch plädieren für ein Verbot von biometrischer Massenüberwachung. Im April stellte die EU-Kommission ihren lang erwarteten Gesetzentwurf zur Regulierung von KI in Europa vor. Einige Anwendungsfälle von biometrischen Erkennungssystemen sollen verboten werden, die meisten nicht. Viele Schlupflöcher bleiben.

Emotion Recognition zum Ausprobieren:

https://emojify.info/

https://www.hownormalami.eu/